Realizamos una comparativa de los tipos de auditoría de algoritmos para poder seleccionar la que más se ajusta a los objetivos al analizar un sistema de Inteligencia Artificial.

Si atendemos a las metas y objetivos que persigue la auditoría algorítmica, encontramos:

- Auditorías de sesgos;

- Auditorías de inspecciones regulatorias.

Sin embargo, si observamos el momento en el que se realiza la auditoría, tenemos:

- Auditorías realizadas en las fases de desarrollo, es decir, antes de poner el sistema en producción o ser lanzado;

- Auditorías realizadas después de lanzarlo y que esté un tiempo en producción.

O bien, el criterio puede ser la cercanía o el nivel de acceso al equipo desarrollador. En este caso, podemos hablar de:

- Auditorías internas;

- Auditorías totalmente externas sin acceso al equipo desarrollador;

- Auditorías acordadas con un tercero.

A continuación, analizamos en detalle las características de cada una de ellas. Primero, atendiendo a los objetivos de la auditoría algorítmica:

Auditorías de sesgos

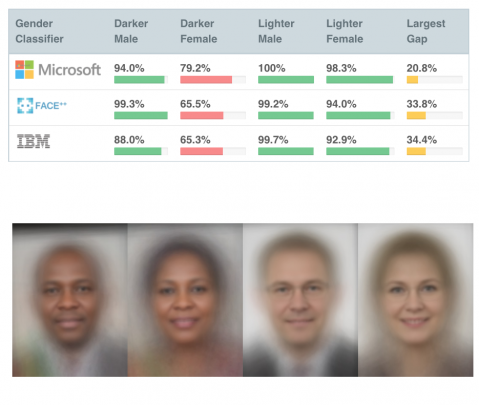

Las auditorias de sesgos identifican posibles discriminaciones a través de los datos. Este tipo de auditoría de algoritmos compara los datos que entran en el sistema con los resultados obtenidos, buscando las discriminaciones y sesgos. Existen diferentes herramientas que facilitan este tipo de auditorías como son Aequitas Bias and Fairness Audit Toolkit o IBM AI Fairness 360 Toolkit. Existen varias auditorias célebres de este tipo, entre las que destaca Gender Shades, que evalúa la precisión de varios productos comerciales de identificación de caras y clasificación de género por computadora, encontrando discriminación basada en género y raza en las tres herramientas analizadas: IBM, Microsoft y Face++.

Auditorías de inspecciones regulatorias

Las inspecciones regulatorias pueden utilizarse para evaluar si un sistema algorítmico cumple con la ley de protección de datos o la legislación sobre igualdad. Los ejemplos más notorios podrían ser el framework de auditorías de inteligencia artificial del ICO en Reino Unido. En él se propone a modo de guía cómo se puede evaluar la responsabilidad y gobernanza, el procesado de datos transparente, legal y equitativo, la mitigación de discriminación, la seguridad y la minimización de los datos. Aquí también entrarían las ‘Ethics guidelines for trustworthy AI’, que detallan los 7 requisitos clave que deben cumplir los sistemas de IA para ser considerados fiables: agencia y supervisión humana, robustez técnica y seguridad, privacidad y gobernanza de datos, transparencia, diversidad, no discriminación y equidad, bienestar social y ambiental, y rendición de cuentas. Sin embargo, ambas guías o marcos de trabajo pueden ser complejos de aplicar al no proporcionar procesos o artefactos propios de un framework.

Siguiendo un criterio temporal, existen dos tipos de auditoría algorítmica dependiendo del momento en que se realiza:

Auditorías realizadas en fase de desarrollo

Las auditorías de sistemas en desarrollo suelen considerarse como evaluaciones de riesgos algorítmicos. Se realizan antes de que se despliegue un sistema con el fin de evaluar las posibles áreas de impacto del sistema y el consiguiente riesgo. Se trata de un proceso interno, por lo que estas auditorías incluyen el escrutinio de detalles no públicos del sistema. Estas evaluaciones de riesgos e impacto revisan cómo podría impactar el sistema en las diferentes personas que lo usen. Además, pueden integrarse como un proceso continuo para monitorizar los posibles cambios en los riesgos o evaluar nuevas funcionalidades del sistema. Son auditorías importantes que deberían complementarse con las auditorías de sistemas en producción, es decir, ya lanzados y donde se pueden observar los usos y decisiones concretas del sistema para un contexto real.

Auditorías realizadas en sistemas ya lanzados

Las auditorías de sistemas en producción o ya lanzados, pueden realizarse como evaluaciones de impacto algorítmico para comprobar los efectos que tiene el sistema en una población en particular. Este tipo de evaluación parece particularmente pertinente en el sector público, donde en algunos casos es cada vez más difícil diferenciar el impacto de las políticas de los sistemas algorítmicos que podrían formar parte de la aplicación de la propia política. Por ejemplo, en 2018, investigadores de Stanford compararon los resultados de los menores acogidos a los servicios de protección infantil tras la implementación de un modelo de predicción de riesgos, con los resultados de los menores antes de la implementación de dicho sistema.

Son evaluaciones profundas y detalladas que miden el impacto antes y después de la puesta en producción. Permiten estudiar el sistema no solo como se planteó por el equipo desarrollador, sino por cómo se está aplicando realmente. Cuando se descubre una ineficiencia, discriminación o sesgo es conveniente volver a empezar el ciclo de desarrollo/auditoría/evaluación de impacto.

Por último, si nos fijamos en la cercanía del equipo auditor con el equipo desarrollador, diferenciamos entre:

Auditoría interna

Las auditorías algorítmicas internas son una revisión interna a la organización que se lleva en paralelo al desarrollo del sistema de inteligencia artificial. Su misión es asegurar que el sistema va a tener un comportamiento codificado en los estándares. Esta constante revisión interna se puede apoyar en frameworks, como por ejemplo el Google’s SMACTR Audit Framework, un tipo de auditoría que propone fases, procesos y artefactos y cuyo objetivo es evaluar en qué medida el producto candidato, una vez en funcionamiento en el mundo real, se ajustará al comportamiento esperado del sistema codificado en las normas de la organización. Otro framework de auditoría interna a considerar es Aletheia Framework , desarrollado por Rolls Royce, donde proponen examinar 32 facetas de impacto social, la gobernanza, la confianza y la transparencia del sistema de AI. Una de las desventajas de este tipo de auditorías es la implicación del equipo auditor y su dependencia de la propia organización, lo que puede producir choques entre los distintos equipos.

Auditorías externas

Las auditorías totalmente externas no tienen acceso al equipo desarrollador del sistema, por lo que solo pueden realizarse probando el sistema como una caja negra. Si bien no es el contexto ideal, estas auditorias también pueden descubrir discriminación y sesgos a través del uso del sistema. Las auditorías externas suelen ser auditorías de sesgos. Un ejemplo de este tipo de auditorías lo encontramos en el paper “Auditando las vías de radicalización en YouTube”.

Auditorías contratadas a terceros

Las auditorías contratadas a terceros son las que ofrecen mayor nivel de escrutinio y efectividad por su equilibrio entre el acceso a los datos no públicos de los sistema y al equipo desarrollador, a la vez que mantienen la independencia al realizarla un equipo externo y no sufrir las presiones que puedan tener las auditorías internas.

Esta auditoría puede cubrir tanto aspectos de sesgos como normativos, con especial énfasis en los posibles impactos y discriminaciones para grupos poblacionales en situación de vulnerabilidad según el contexto de aplicación del sistema, así como la explicabilidad y la aceptabilidad del mismo. Además, es posible aplicarlo tanto para sistemas en desarrollo como para sistemas puestos ya en producción.

Este marco de trabajo cuenta con distintas fases, desde un estudio preliminar para conocer los datos básicos del sistema y su mapeo en profundidad, un plan de análisis donde se exponen los grupos de población a estudiar y los métodos cualitativos y cuantitativos que van a ser usados, el análisis que lleva a cabo el estudio del plan y, por último, el informe final que recoge toda esta información junto con conclusiones y recomendaciones. Puedes ver un resumen de los cinco principales pasos en este otro post.

Para hacer esta tecnología más explicable, transparente y controlable, y acercarla a Estados, empresas y a la ciudadanía, Eticas Consulting ha publicado una Guía de Auditoría Algorítmica que puedes descargar aquí, y donde se detalla el marco de trabajo más adecuado. Se trata de una metodología basada en la experiencia de auditar algoritmos durante más de dos años, liderando este campo a nivel internacional.

Por último, esta clasificación nos muestra distintas formas de aproximarnos a una auditoría algorítmica, si bien debemos tener en mente que, lo importante, es realizarlas. Las consecuencias de usar un sistemas de Inteligencia Artificial mal diseñado, que gestiona mal los datos o toma decisiones con sesgos, incluyen el plano económico y legal según la discriminación que generen, hasta riesgos reputacionales y la consecuente pérdida de confianza.